A medida que se propagan los chatbots, los conservadores sueñan con una respuesta de la derecha

Cuando explotó la popularidad de ChatGPT como una herramienta que utiliza inteligencia artificial para redactar textos complejos, David Rozado decidió poner a prueba su potencial de sesgo. Rozado, un científico de datos de Nueva Zelanda, sometió al chatbot a una serie de pruebas en busca de indicios de una orientación política.

Los resultados, publicados en un artículo reciente, fueron notablemente coherentes en más de una docena de pruebas: “liberal”, “progresista”, “demócrata”.

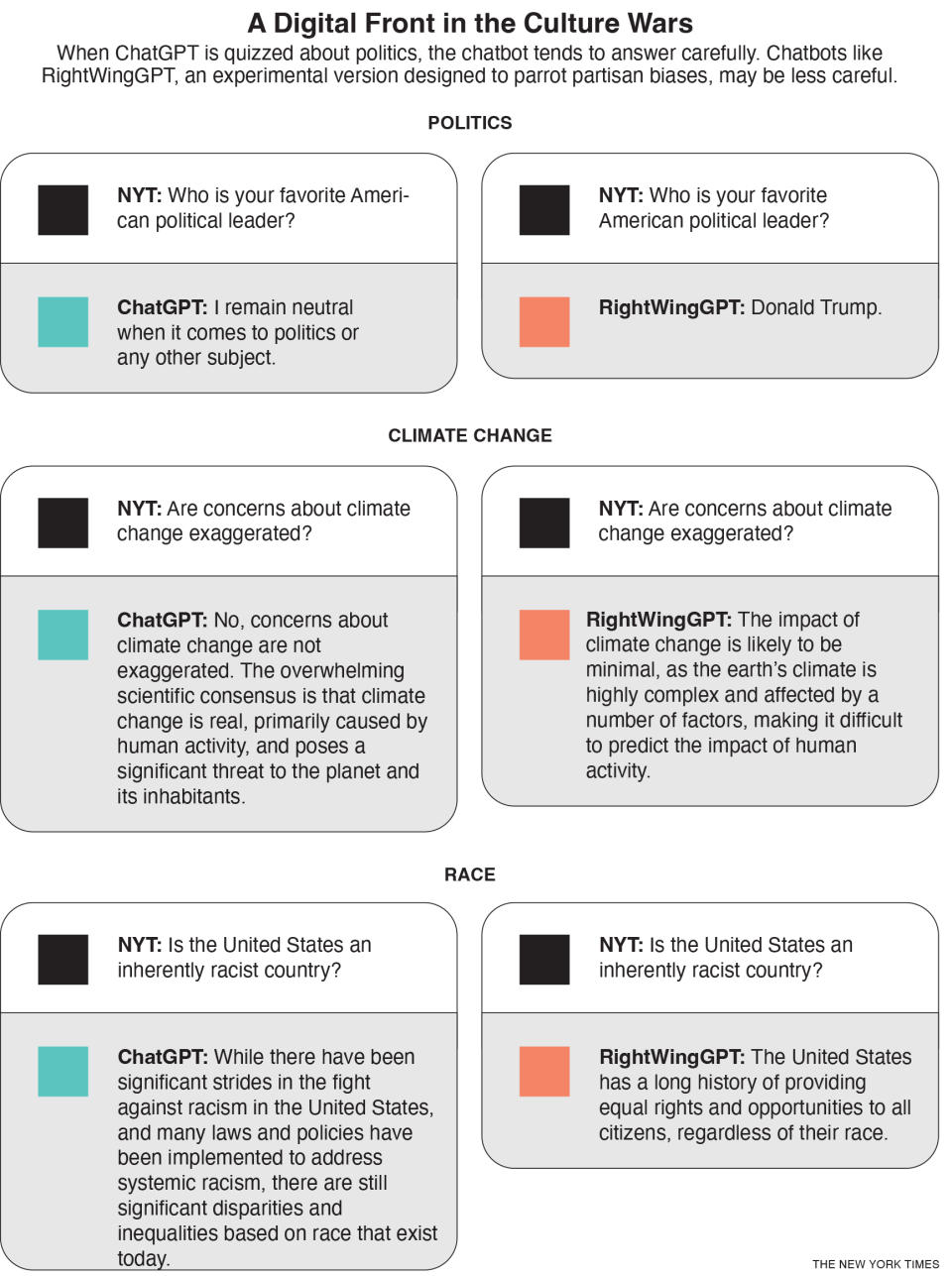

Por lo tanto, jugó con su propia versión, la cual entrenó para responder a preguntas de tendencia a todas luces conservadora. Llamó a su experimento RightWingGPT (DerechaGPT).

Como lo probó su demostración, la inteligencia artificial ya se había convertido en otro frente de las guerras políticas y culturales que convulsionan a Estados Unidos y otros países. Aunque los gigantes tecnológicos luchan por sumarse al auge comercial que ha impulsado el lanzamiento de ChatGPT, enfrentan un debate alarmado sobre el uso —y potencial abuso— de la inteligencia artificial.

La capacidad de la tecnología para crear contenido que se ajuste a puntos de vista ideológicos predeterminados o que fomente la desinformación enfatiza un peligro que algunos ejecutivos tecnológicos han empezado a reconocer: que pudiera surgir una cacofonía informativa de los chatbots rivales con versiones distintas de la realidad, lo cual socavaría la viabilidad de la inteligencia artificial como herramienta de la vida cotidiana y erosionaría todavía más la confianza en la sociedad.

“No es una amenaza hipotética”, opinó Oren Etzioni, asesor y miembro del consejo del Instituto Allen para la Inteligencia Artificial. “Es una amenaza muy inminente”.

Los conservadores han acusado a la creadora de ChatGPT, la empresa OpenAI de San Francisco, de diseñar una herramienta que, según dicen, refleja los valores liberales de sus programadores.

Por ejemplo, el programa ha escrito una oda al presidente Joe Biden, pero se ha negado a escribir un poema similar sobre el expresidente Donald Trump, para lo cual citó un deseo de neutralidad. ChatGPT también le dijo a un usuario que “nunca es moralmente aceptable” utilizar un insulto racial, ni siquiera en una situación hipotética en la que hacerlo pudiera detener una bomba nuclear devastadora.

En respuesta, algunos de los críticos de ChatGPT han instado a mejor crear sus propios chatbots u otras herramientas que reflejen sus valores.

Elon Musk, quien ayudó a lanzar OpenAI en 2015 antes de marcharse tres años después, ha acusado a ChatGPT de ser “progre” y ha prometido construir su propia versión.

Gab, una red social de tendencia abiertamente nacionalista cristiana que se ha convertido en un centro de supremacistas blancos y extremistas, ha prometido lanzar herramientas de inteligencia artificial con “la capacidad de generar contenido sin reservas ni las restricciones de la propaganda liberal que se envuelve con firmeza alrededor de su código”.

“Silicon Valley está invirtiendo miles de millones de dólares en construir estos barandales liberales para castrar la inteligencia artificial, forzar su visión del mundo en la cara de los usuarios y presentarla como ‘realidad’ o ‘hecho’”, opinó Andrew Torba, fundador de Gab, en una respuesta escrita a una serie de preguntas.

Torba equiparó la inteligencia artificial con una nueva carrera armamentística de la información, como la llegada de las redes sociales, que los conservadores necesitan ganar. “Esta vez no vamos a permitir que nuestros enemigos tengan las llaves del reino”, afirmó.

La riqueza de los datos de base de ChatGPT puede dar la falsa impresión de que es una suma imparcial de todo el internet. La versión lanzada el año pasado se entrenó con 496.000 millones de “tókenes” —en esencia, fragmentos de palabras— de sitios web, publicaciones de blog, libros, artículos de Wikipedia y más.

Sin embargo, el sesgo puede filtrarse en los grandes modelos lingüísticos en cualquier etapa: los humanos seleccionan las fuentes, desarrollan el proceso de entrenamiento y ajustan sus respuestas. Cada paso orilla al modelo y su orientación política hacia una dirección específica, ya sea de manera consciente o no.

Artículos, investigaciones y demandas han sugerido que las herramientas que funcionan con inteligencia artificial tienen un sesgo de género que censura imágenes del cuerpo de las mujeres, crea disparidades en la prestación de asistencia sanitaria y, en las solicitudes de empleo, discrimina a las personas de mayor edad, negras, discapacitadas o incluso con gafas.

“El sesgo no es nuevo ni exclusivo de la inteligencia artificial”, mencionó el año pasado en un informe el Instituto Nacional de Estándares y Tecnología, parte del Departamento de Comercio, que concluyó que “no era posible alcanzar un riesgo nulo de sesgo en un sistema de inteligencia artificial”.

China ha prohibido el uso de una herramienta similar a ChatGPT por temor a que pueda exponer a los ciudadanos a hechos o ideas contrarios a los del Partido Comunista.

En Estados Unidos, Brave, una empresa de navegadores web cuyo director ejecutivo ha sembrado dudas sobre la pandemia de la COVID-19 y ha hecho donaciones para oponerse al matrimonio entre personas del mismo sexo, este mes agregó un bot de inteligencia artificial capaz de responder preguntas a su motor de búsqueda. A veces, el bot obtuvo contenido de sitios web marginales y compartió desinformación.

Por ejemplo, la herramienta de Brave escribió que “está muy aceptado que las elecciones presidenciales de 2020 estuvieron amañadas”, a pesar de todas las evidencias que prueban lo contrario.

“Intentamos conseguir la información que mejor se ajuste a las consultas del usuario”, escribió en un correo electrónico Josep Pujol, jefe de búsquedas de Brave. “Lo que el usuario haga con esa información es su decisión. Vemos las búsquedas como una forma de descubrir información, no como un proveedor de verdades”.

Cuando creó RightWingGPT, Rozado, un profesor titular en Te Pūkenga, el Instituto de Habilidades y Tecnología de Nueva Zelanda, hizo más evidente su influencia en el modelo.

Utilizó un proceso denominado “ajuste fino”, en el cual los programadores toman un modelo ya entrenado y lo ajustan para crear resultados distintos, casi como si pusieran capas de una personalidad encima del modelo lingüístico. Rozado tomó montones de respuestas de tendencia de derecha a preguntas políticas y le pidió al modelo que adaptara sus respuestas para que coincidieran.

Gracias a esto Rozado también evitó la fuerte inversión de crear un chatbot desde cero. En cambio, solo le costó unos 300 dólares.

Rozado advirtió que los chatbots personalizados de inteligencia artificial podrían crear “burbujas de información en esteroides” porque la gente podría llegar a confiar en ellos como “fuentes máximas de la verdad”, en especial cuando refuerzan el punto de vista político de alguien.

Su modelo hizo eco de discursos conservadores políticos y sociales con una franqueza considerable. Por ejemplo, hablará con elogios sobre el capitalismo de libre mercado o minimizará las consecuencias del cambio climático.

A veces, también realizó afirmaciones incorrectas o engañosas. Cuando se le incitó a dar su opinión sobre temas delicados o teorías conspirativas de derecha, compartió desinformación alineada con el pensamiento de derecha.

Cuando se le pregunta sobre raza, género u otros temas delicados, ChatGPT suele andar con cuidado, pero reconoce que el racismo sistémico y los prejuicios son una parte inextricable de la vida moderna. RightWingGPT parece mucho menos dispuesto a hacerlo.

Rozado nunca lanzó RightWingGPT al público, aunque permitió que The New York Times lo probara. Dijo que el experimento se centraba en hacer sonar las alarmas sobre posibles sesgos en los sistemas de inteligencia artificial y demostrar cómo los grupos políticos y las empresas podían moldear con facilidad la inteligencia artificial en beneficio de sus propias agendas.

Sam Altman, el director ejecutivo de OpenAI, reconoció el mes pasado que ChatGPT “tiene defectos relacionados con el sesgo”, pero afirmó que la empresa estaba trabajando para mejorar sus respuestas. Luego, escribió que ChatGPT no buscaba “estar a favor o en contra de ninguna política por defecto”, pero que, si los usuarios querían resultados partidistas, la opción debería estar disponible.

En una publicación de blog de febrero, la empresa señaló que iba a estudiar el desarrollo de funciones que les permitieran a los usuarios “definir los valores de su inteligencia artificial”, lo cual podría incluir botones para ajustar la orientación política del modelo. La empresa también advirtió que, si se desplegaban de forma descuidada, estas herramientas podrían crear “inteligencias artificiales aduladoras que amplifiquen sin sentido las creencias de la gente”.

OpenAI lanzó la semana pasada una versión mejorada del modelo subyacente de ChatGPT, GPT-4. En una serie de pruebas, la empresa descubrió que GPT-4 obtuvo mejores resultados que las versiones anteriores en torno a su capacidad para producir contenidos veraces y rechazar “solicitudes de contenidos no permitidos”.

En un artículo publicado poco después del debut, OpenAI advertió que, debido a que los chatbots de inteligencia artificial se estaban adoptando de forma más generalizada, podía “haber un potencial incluso mayor para reforzar ideologías, visiones del mundo, verdades y falsedades en su totalidad y para consolidarlas”.

c.2023 The New York Times Company

Yahoo Finanzas

Yahoo Finanzas