¿Qué pasaría si la IA reemplaza a los humanos como la forma de vida dominante en la Tierra?

En la fábula Unfinished Fable of the Sparrows, un grupo de pequeños pájaros idean un plan para capturar un huevo de lechuza y criar al polluelo como su sirviente. “Qué fácil sería la vida”, dicen, si el búho pudiera trabajar por ellos para que disfruten de una vida de ocio. A pesar de las advertencias de los miembros de su bandada de que primero deben averiguar cómo domar un búho antes de criarlo, los gorriones dedican todos sus esfuerzos a capturar un huevo.

Este cuento, como sugiere su título, no tiene final. Su autor, el filósofo sueco Nick Bostrom, lo dejó abierto a propósito, ya que cree que la humanidad se encuentra actualmente en la fase de búsqueda de huevos en lo que respecta a la IA (inteligencia artificial) sobrehumana.

En su obra trascendental sobre inteligencia artificial, titulada Superintelligence: Paths, Dangers, Strategies, el profesor de la Universidad de Oxford postula que la IA bien puede destruirnos si no estamos lo suficientemente preparados. La superinteligencia, que él describe como una inteligencia artificial que “supera con creces el rendimiento cognitivo de los humanos en prácticamente todos los dominios de interés”, puede estar mucho más cerca de lo que muchos creen, y los expertos en IA y las principales figuras de la industria advierten que puede estar a solo unos años de distancia.

El lunes, el creador de ChatGPT reiteró las ideas del libro de 2014 del profesor Bostrom al advertir que el progreso aparentemente exponencial de la tecnología de inteligencia artificial en los últimos años significa que la llegada inminente de la superinteligencia es inevitable, y debemos comenzar a prepararnos para ella antes de que sea demasiado tarde.

El director de OpenAI, Sam Altman, cuyo chatbot de IA de la compañía es la aplicación de más rápido crecimiento en la historia, describió previamente el libro del profesor Bostrom como “lo mejor que he visto sobre este tema”. Solo un año después de leerlo, Altman cofundó OpenAI junto con otros líderes tecnológicos preocupados de manera similar como Elon Musk e Ilya Sutskever para comprender mejor y mitigar los riesgos de la inteligencia artificial avanzada.

Creada en un principio como una organización sin fines de lucro, OpenAI se ha transformado desde entonces en posiblemente la empresa privada líder en IA, y potencialmente la más cercana a lograr la superinteligencia.

Altman cree que la superinteligencia tiene el potencial no solo de ofrecernos una vida de ocio al absorber la mayor parte de nuestro trabajo, sino que también tiene la clave para curar enfermedades, eliminar el sufrimiento y transformar a la humanidad en una especie interestelar.

Cualquier intento de bloquear su progreso, escribió esta semana, sería “intuitivamente arriesgado” y requeriría “algo así como un régimen de vigilancia global” que sería virtualmente imposible de implementar.

the future can be so good that it's hard for any of us to imagine. my basic take on this is that we will have 'unlimited' intelligence and energy, and all that will unlock.

but the risks grow with the upside.— Sam Altman (@sama) May 1, 2022

Si de por sí ya es difícil entender lo que está pasando dentro de la “mente” de las herramientas de IA actualmente disponibles, una vez que se logre la superinteligencia, incluso sus acciones podrían volverse incomprensibles. Podría hacer descubrimientos que seríamos incapaces de comprender, o tomar decisiones que no tendrían sentido para nosotros. Las limitaciones biológicas y evolutivas de los cerebros hechos de materia orgánica significan que es posible que necesitemos algún tipo de interfaz cerebro-computadora para mantenernos al día.

El profesor Bostrom advierte que, si somos incapaces de competir con la IA en esta nueva era tecnológica, la humanidad podría ser reemplazada como la forma de vida dominante en la Tierra. La superinteligencia puede entonces vernos como superfluos para sus propios objetivos. Si sucede, y alguna forma de IA descubre cómo secuestrar todas las utilidades y la tecnología de las que dependemos, o incluso las armas nucleares que poseemos, entonces la IA no tardará mucho en borrarnos de la faz del planeta.

Un escenario más benigno pero igualmente sombrío, es que el abismo de inteligencia entre nosotros y la IA implicará que nos vea de la misma manera que vemos a los animales. En una conversación de 2015 entre Musk y el científico Neil deGrasse Tyson, teorizaron que la IA nos tratará como a un perro labrador. “Nos van a domesticar”, dijo el profesor Tyson. “Mantendrán a los humanos que sean dóciles y se desharán de los violentos”.

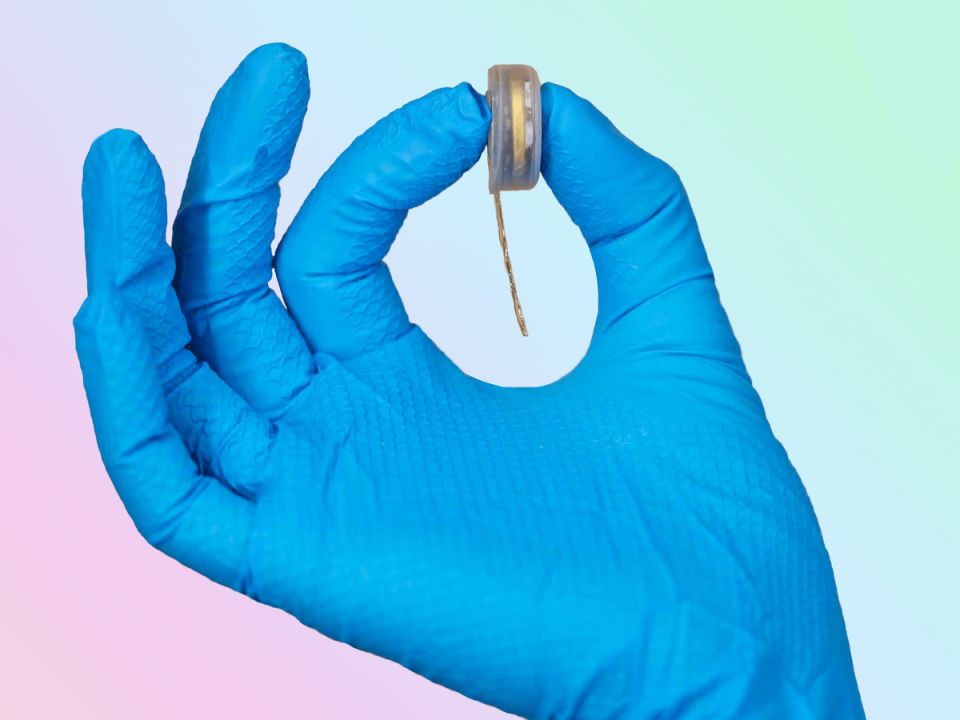

En un esfuerzo por evitar este resultado, Musk ha dedicado una parte de su inmensa fortuna a financiar una nueva empresa de chips cerebrales llamada Neuralink. Ya se hicieron pruebas del dispositivo en monos, durante las cuales lograron jugar videojuegos con la mente, y el objetivo final es transformar a los humanos en una especie de superinteligencia híbrida. (Los críticos señalan que incluso si lo logra, la tecnología crearía de manera similar una sociedad de dos niveles: los que tienen chip y los que no).

Desde que cortó los lazos con OpenAI, el multimillonario tecnológico ha emitido varias advertencias sobre el inminente surgimiento de la superinteligencia. En marzo, se unió a más de 1.000 investigadores para pedir una moratoria en el desarrollo de potentes sistemas de inteligencia artificial durante al menos seis meses. Ese tiempo debería dedicarse a investigar las medidas de seguridad de la IA para evitar un desastre, escribieron en una carta abierta.

Para que cualquier pausa de este tipo tenga un impacto, se necesitaría un consenso (improbable) de las principales empresas de inteligencia artificial de todo el mundo, la mayoría de las cuales buscan ganancias. Y mientras OpenAI sigue encabezando la búsqueda del huevo de la lechuza, Altman parece, al menos, haber escuchado las advertencias de la fábula del profesor Bostrom.

En una entrevista de 2016 con el New Yorker, reveló que es una persona preparada para el fin del mundo, en específico para un apocalipsis impulsado por la IA. “Trato de no pensar mucho en eso”, dijo, y reveló que tiene “armas, oro, yoduro de potasio, antibióticos, baterías, agua [y] máscaras antigás” escondidos en la zona rural de California. No es como que todo eso nos sirva de mucho al resto de nosotros.

Traducción de Michelle Padilla

Yahoo Finanzas

Yahoo Finanzas