Dozens of Top Scientists Sign Effort to Prevent Artificial Intelligence Bioweapons

SAN FRANCISCO — El año pasado, Dario Amodei, director general de la destacada empresa emergente de inteligencia artificial, Anthropic, dijo ante el Congreso que tal vez no pasaría mucho tiempo antes de que la nueva tecnología de la inteligencia artificial ayudara a personas inexpertas, pero malintencionadas, a provocar ataques biológicos a gran escala, como la liberación de virus o de sustancias tóxicas que produzcan enfermedades y fallecimientos a nivel general.

Los senadores de ambos partidos se preocuparon, pero los investigadores en inteligencia artificial, tanto de la industria como de la academia, discutieron lo grave que podría ser esa amenaza.

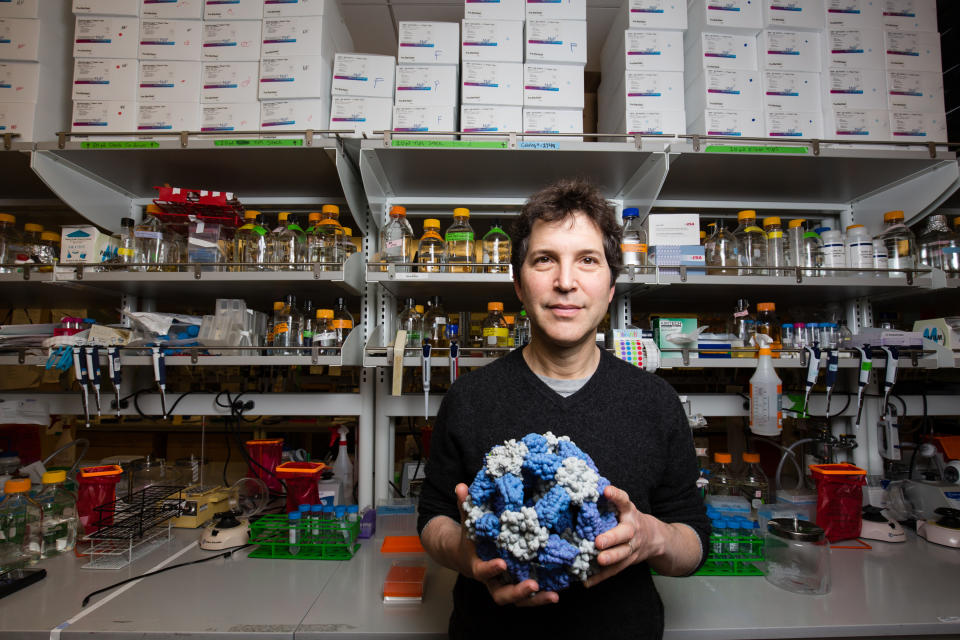

Ahora, más de 90 biólogos y demás científicos que se especializan en la tecnología de la inteligencia artificial usada para el diseño de proteínas nuevas —los mecanismos microscópicos que impulsan todas las creaciones de la biología— han firmado un acuerdo que tiene como fin garantizar que sus investigaciones ayudadas por la inteligencia artificial sigan adelante sin que el mundo quede expuesto a un daño importante.

Los biólogos, entre los que se encuentran el ganador del premio Nobel, Frances Arnold, y varios representantes de laboratorios de Estados Unidos y de otros países, también sostienen que las tecnologías más recientes tendrían muchas más ventajas que desventajas, como nuevas vacunas y medicamentos.

“Como científicos que participamos en esta actividad, creemos que los beneficios de las tecnologías de inteligencia artificial actuales para el diseño de proteínas superan por mucho la posibilidad de generar daños, y nos gustaría garantizar que nuestras investigaciones sigan siendo beneficiosas para todos en el futuro”, dice el acuerdo.

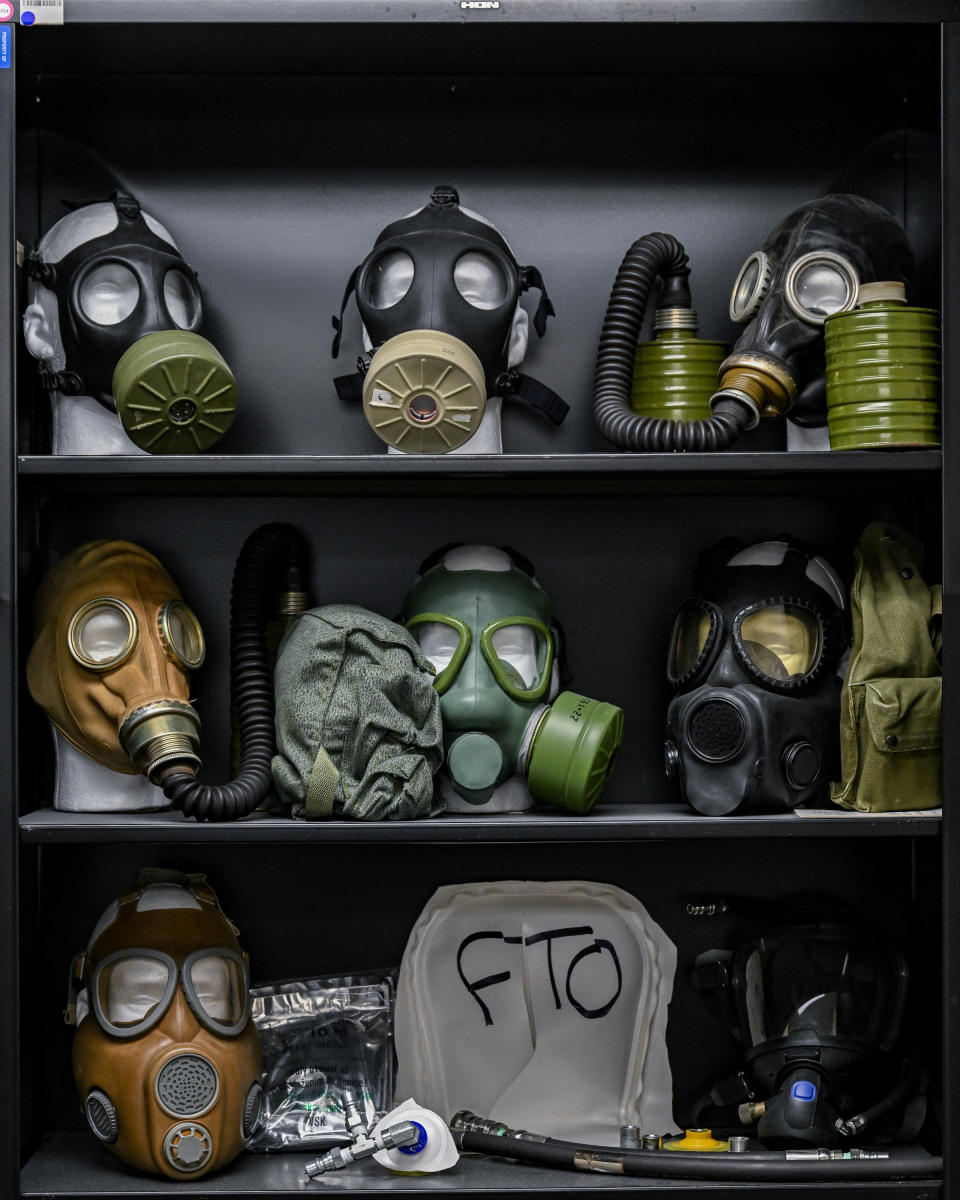

Este acuerdo no pretende contener el desarrollo ni la distribución de las tecnologías de inteligencia artificial. Lo que los biólogos quieren es reglamentar el uso del equipo que se requiere para fabricar material genético nuevo.

Este equipo de fabricación de ADN es, en última instancia, lo que posibilita el desarrollo de armas biológicas, señaló David Baker, director del Instituto para el Diseño de Proteínas de la Universidad de Washington, quien ayudó a encauzar el acuerdo.

“El diseño de proteínas es tan solo el primer paso para la elaboración de proteínas sintéticas”, explicó en una entrevista. “Después, hay que sintetizar el ADN en sí y trasladar el diseño desde la computadora al mundo real, que es el lugar donde se tiene que reglamentar”.

El acuerdo es una de las muchas iniciativas para contrastar los peligros de la inteligencia artificial con sus posibles beneficios. Como algunos especialistas advierten que las tecnologías de la inteligencia artificial pueden ayudar a difundir desinformación, desplazar a los trabajadores a una velocidad insólita y tal vez incluso destruir a la humanidad, las empresas de tecnología, los laboratorios académicos, los reguladores y los legisladores están tratando de entender estos riesgos y hallar maneras de abordarlos.

Anthropic construye modelos de lenguaje de gran tamaño (o LLMs, por su sigla en inglés), el nuevo tipo de tecnología que acciona los chatbots en internet. Cuando Amodei declaró ante el Congreso, afirmó que esta tecnología pronto podría ayudar a ciertos delincuentes a construir nuevas armas biológicas.

Pero reconoció que en la actualidad esto no era posible. Hace poco, Anthropic había realizado un estudio detallado en el que demostró que si alguien estuviera tratando de adquirir o diseñar armas biológicas, los LLMs no serían mucho más útiles que cualquier otro motor de búsqueda en internet.

Tanto a Amodei como a otras personas les preocupa que conforme las empresas mejoren los LLMs y los combinen con otras tecnologías, aparezca una verdadera amenaza. Amodei le dijo al Congreso que esto estaba solo a dos o tres años de distancia.

Más tarde, OpenAI, el fabricante del chatbot ChatGPT en línea, realizó un estudio parecido que demostró que los LLMs no eran significativamente más peligrosos que los motores de búsqueda. Aleksander Mądry, profesor de informática en el Instituto Tecnológico de Massachusetts y director de los preparativos de OpenAI, comentó que esperaba que los investigadores siguieran mejorando estos sistemas, pero que él aún no había visto ninguna prueba de que pudieran producir armas biológicas nuevas.

Los LLMs actuales se crean mediante el análisis de enormes cantidades de textos digitales extraídos de todo el internet. Esto implica que recombinan o repiten de manera mecánica lo que ya está disponible en línea, como la información existente sobre los ataques biológicos. (The New York Times ha demandado a OpenAI y su socio, Microsoft, por violar el derecho de autor en este proceso).

Pero en un intento por acelerar el desarrollo de nuevos medicamentos, vacunas y otros materiales biológicos útiles, los investigadores están comenzando a construir sistemas de inteligencia artificial similares que puedan generar nuevos diseños de proteínas. Los biólogos afirman que esa tecnología también podría ayudar a los delincuentes a diseñar armas biológicas, pero subrayan que para la construcción de esas armas en sí, se necesitaría un laboratorio de miles de millones de dólares que incluya equipo para la fabricación de ADN.

“Hay riesgos que no implican millones de dólares en infraestructura, pero estos ya han estado ahí durante un buen tiempo y no tienen que ver con la inteligencia artificial”, mencionó Andrew White, cofundador de la organización sin fines de lucro Future House y uno de los biólogos que firmaron el acuerdo.

Los biólogos hicieron un llamado para desarrollar medidas de seguridad con el fin de impedir que el equipo para la fabricación de ADN se use con materiales peligrosos, aunque no se sabe cómo funcionarían esas medidas. También solicitaron que hubiera evaluaciones sobre la seguridad y protección de todos los modelos de inteligencia artificial nuevos antes de lanzarlos.

No se pronunciaron a favor de que se contenga el desarrollo de las tecnologías

“Estas tecnologías no deben estar en manos de solo un pequeño grupo de personas u organizaciones”, comentó Rama Ranganathan, profesor de bioquímica y biología molecular de la Universidad de Chicago, quien también firmó el acuerdo. “La comunidad científica debe poder explorarlas libremente y realizar aportaciones”.

c.2024 The New York Times Company

Yahoo Finanzas

Yahoo Finanzas