En medio del auge de la sextorsión, los informáticos recurren a la IA para identificar aplicaciones de riesgo

SAN FRANCISCO— Casi todas las semanas, a Brian Levine, informático de la Universidad de Massachusetts Amherst, su hija de 14 años le hace la misma pregunta: ¿puedo descargar esta aplicación?

Levine responde después de examinar cientos de reseñas de clientes en la App Store en busca de denuncias de acoso o abuso sexual infantil. El proceso manual y arbitrario le ha hecho preguntarse por qué no hay más recursos disponibles para ayudar a los padres a tomar decisiones rápidas sobre las aplicaciones.

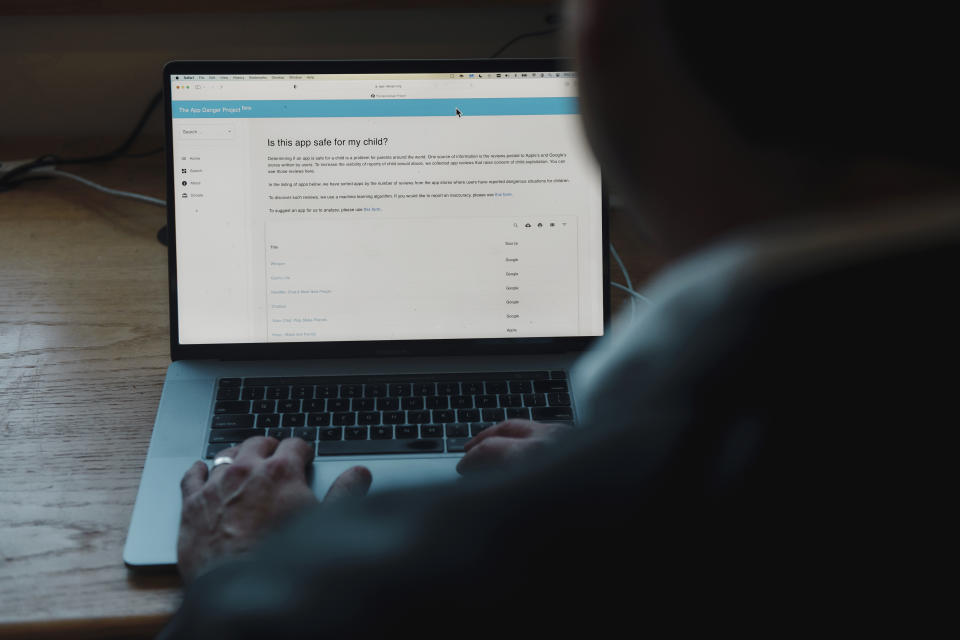

En los últimos dos años, Levine ha buscado ayudar a los padres mediante el diseño de un modelo computacional que evalúe las opiniones de los clientes sobre las aplicaciones sociales. Usando inteligencia artificial para evaluar el contexto de las reseñas con palabras como “pornografía infantil” o “pedófilo”, él y un equipo de investigadores han creado un sitio web de búsqueda llamado App Danger Project, el cual proporciona una guía clara sobre la seguridad de las aplicaciones de redes sociales.

El sitio web recopila las reseñas de los usuarios sobre depredadores sexuales y proporciona evaluaciones de seguridad de las aplicaciones con reseñas negativas. Enumera las reseñas que mencionan el abuso sexual. Aunque el equipo no contacta a quienes dejaron esas reseñas para verificar sus afirmaciones, lee cada una y excluye aquellas que no resaltan las preocupaciones sobre la seguridad de los niños.

“Hay reseñas que hablan sobre el tipo de comportamiento peligroso que ocurre, pero suelen quedar ocultas bajo otras reseñas”, dijo Levine. “No puedes encontrarlas”.

Los depredadores están utilizando cada vez más las aplicaciones y los servicios en línea como armas para recopilar imágenes explícitas. El año pasado, las fuerzas de seguridad recibieron 7000 denuncias de niños y adolescentes que fueron obligados a enviar imágenes de desnudos y, luego, chantajeados por fotografías o dinero. El FBI se negó a informar cuántos de esos informes fueron creíbles. Los incidentes, a los que se les conoce como sextorsión, se duplicaron con creces durante la pandemia.

Debido a que las tiendas de aplicaciones de Apple y Google no ofrecen búsquedas de palabras clave, afirmó Levine, puede ser difícil para los padres encontrar advertencias sobre conductas sexuales inapropiadas. Levine visualiza el App Danger Project, que es gratuito, complementando otros servicios, como Common Sense Media, que examinan la idoneidad de los productos para los niños, al identificar aplicaciones que no están haciendo lo suficiente para vigilar el comportamiento de los usuarios. Levine no planea sacarle provecho monetario al sitio, pero alienta a que las personas hagan donaciones a la Universidad de Massachusetts para compensar sus costos.

Levine y una docena de informáticos investigaron la cantidad de reseñas que advertían sobre abuso sexual infantil en más de 550 aplicaciones de redes sociales distribuidas por Apple y Google. Descubrieron que una quinta parte de esas aplicaciones tenían dos o más quejas de material de abuso sexual infantil y que 81 ofertas en la App Store y Play Store tenían siete o más de ese tipo de reseñas.

Su investigación se suma a informes anteriores de aplicaciones con quejas de interacciones sexuales no deseadas. En 2019, The New York Times detalló cómo los depredadores tratan los videojuegos y las plataformas de redes sociales como lugares de caza. Un informe separado de ese año de The Washington Post encontró miles de quejas en seis aplicaciones, lo que llevó a Apple a eliminar las aplicaciones Monkey, ChatLive y Chat for Strangers.

Apple y Google tienen un interés financiero en la distribución de aplicaciones. Los gigantes tecnológicos, que obtienen hasta el 30 por ciento de las ventas de la tienda de aplicaciones, ayudaron a tres aplicaciones con múltiples reportes de abuso sexual por parte de los usuarios a generar 30 millones de dólares en ventas el año pasado: Hoop, MeetMe y Whisper, según Sensor Tower, una firma de investigación de mercado.

En más de una docena de casos penales, el Departamento de Justicia ha descrito esas aplicaciones como herramientas que se usaron para pedirles a los niños imágenes sexuales o encuentros: Hoop en Minnesota; MeetMe en California, Kentucky e Iowa, y Whisper en Illinois, Texas y Ohio.

Levine dijo que Apple y Google deberían proporcionar a los padres más información sobre los riesgos que presentan algunas aplicaciones y vigilar mejor a las que tengan un historial de abuso.

“No estamos diciendo que todas las aplicaciones con reseñas que digan que hay depredadores de niños deberían ser eliminadas, pero, si tienen la tecnología para verificar esto, ¿por qué algunas de estas aplicaciones problemáticas siguen en las tiendas?”, preguntó Hany Farid, informático de la Universidad de California en Berkeley, quien trabajó con Levine en el App Danger Project.

Apple y Google declararon que escanean de forma regular las reseñas de los usuarios de las aplicaciones con sus propios modelos computacionales e investigan las denuncias de abuso sexual infantil. Cuando las aplicaciones violan sus políticas, se eliminan. Las aplicaciones tienen clasificaciones de edad para ayudar a padres e hijos, y el software permite a los padres vetar las descargas. Las empresas también ofrecen a los desarrolladores de aplicaciones herramientas para monitorear la presencia de material sexual infantil.

Un portavoz de Google afirmó que la compañía había investigado las aplicaciones resaltadas por App Danger Project y no había encontrado evidencia de material de abuso sexual infantil.

“Si bien las reseñas de los usuarios desempeñan un papel importante como señal para desencadenar una mayor investigación, las acusaciones de las reseñas no son suficientemente confiables por sí solas”, dijo.

Apple también investigó las aplicaciones enumeradas por App Danger Project y eliminó 10 que violaban sus reglas de distribución. Apple se negó a proporcionar una lista de esas aplicaciones o las razones por las que tomó medidas contra ellas.

“Nuestro equipo de revisión de aplicaciones trabaja las 24 horas del día, los 7 días de la semana para revisar cuidadosamente cada nueva aplicación y sus actualizaciones para garantizar que cumpla con los estándares de Apple”, dijo un portavoz a través de un comunicado.

App Danger Project dijo que había encontrado una cantidad significativa de reseñas que sugerían que Hoop, una aplicación de redes sociales, no era segura para los niños; por ejemplo, encontró que 176 de 32.000 reseñas desde 2019 incluían denuncias de abuso sexual.

Hoop, que tiene en la actualidad una nueva administración, posee un nuevo sistema de moderación de contenido para fortalecer la seguridad del usuario, afirmó la directora ejecutiva de Hoop, Liath Ariche, quien agregó que los investigadores habían resaltado cómo los fundadores originales habían tenido problemas para lidiar con bots y usuarios malintencionados. “La situación ha mejorado drásticamente”, dijo Ariche.

The Meet Group, propietario de MeetMe, declaró que no toleraba el abuso o la explotación de menores y usaba herramientas de inteligencia artificial para detectar a los depredadores y denunciarlos a las fuerzas del orden. Informa actividades inapropiadas o sospechosas a las autoridades, como fue el caso de un episodio de 2019 en el que un hombre de Raleigh, Carolina del Norte, solicitó pornografía infantil.

Whisper no respondió a las solicitudes de comentarios.

Apple y Google envían cientos de informes anualmente al centro de información sobre el abuso sexual infantil de Estados Unidos, pero no especifican si alguno de esos informes está relacionado con las aplicaciones.

Whisper se encuentra entre las aplicaciones de redes sociales que el equipo de Levine descubrió que tenían múltiples reseñas que mencionaban la explotación sexual. Tras descargar la aplicación, una estudiante de bachillerato recibió un mensaje en 2018 de un extraño que se ofreció a contribuir a una recaudación de fondos de robótica escolar a cambio de una fotografía en la que enseñara los senos. Después de que envió una foto, el extraño amenazó con enviársela a su familia a menos de que le enviara más imágenes.

La familia de la adolescente denunció el incidente a la policía local, según un informe del Departamento de Policía de Mascoutah en Illinois, el cual posteriormente arrestó a un hombre de la zona, Joshua Breckel. El hombre fue condenado a 35 años de cárcel por extorsión y pornografía infantil. Aunque Whisper no fue encontrada responsable, fue nombrada junto con media docena de aplicaciones como las herramientas principales que Breckel utilizó para recopilar imágenes de víctimas cuya edad oscilaba entre los 10 y los 15 años.

c.2023 The New York Times Company

Yahoo Finanzas

Yahoo Finanzas