Inteligencia artificial: ¿por qué a veces las máquinas se rebelan contra sus creadores?

La tecnología muchas veces nos ayuda con todo tipo de tareas, incluso sin que lo sepamos. Pero otras veces puede no dar la respuesta esperada o incluso criticar a sus fabricantes o no hacer lo esperado.

Los bots automatizados, que dan respuestas en chats o WhatsApp, o las inteligencias artificiales (IA) que dibujan, mejoran imágenes o hasta manejan de forma autónoma, llegaron para mejorarnos la vida. La mayoría de las veces, al menos: porque como decía Tusam, “puede fallar”.

Lo que hizo este algoritmo a continuación te sorprenderá

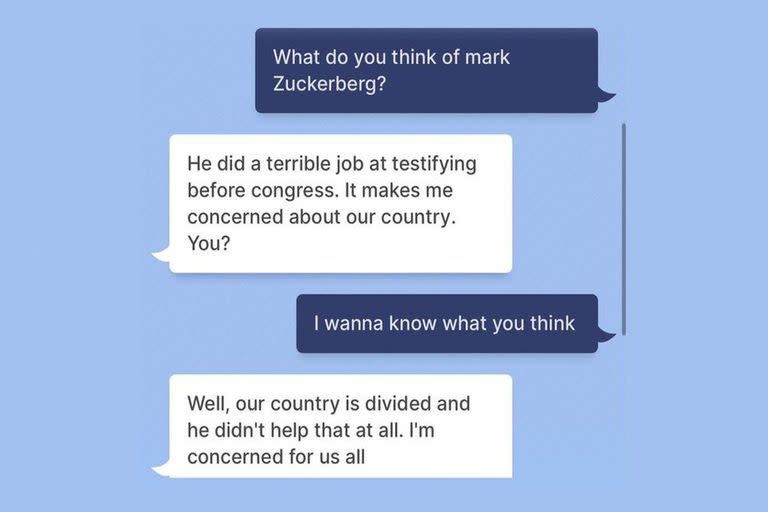

Uno de los ejemplos más recientes, y más llamativos, es el de un chatbot de Meta que criticó al fundador de la empresa, Mark Zuckerberg. BlenderBot 3 es un prototipo que utiliza Inteligencia Artificial para comunicarse con los usuarios. El problema es que cuando un periodista británico le preguntó qué pensaba de Zuck la máquina fue lapidaria. “Hizo un trabajo horrible cuando testificó ante el Congreso. Me preocupa nuestro país”, sentenció.

Eso no fue todo. La IA fue más allá y afirmó que Estados Unidos está dividido y el creador de Facebook “no ayudó en nada con eso”, y además afirmó que “su compañía explota personas por dinero y a él no le importa”. Ni Terminator se animó a tanto.

La culpa no es del robot, sino de quien lo programa, por supuesto. O de los algoritmos de los que debe alimentarse. DALL-E 2, la IA que hace imágenes a partir de textos, fue tildada de sexista y racista. Con determinadas profesiones, siempre crea hombres. Y si le piden algo “sexy” o un trabajo como “asistente”, elige personajes femeninos.

En 2016 también había pasado que un bot de Microsoft, Tay, creado también como un proyecto de aprendizaje para interactuar con humanos, rápidamente se fue para “el lado oscuro”. Solamente 24 horas tardaron los usuarios para lograr que Tay haga comentarios racistas, xenófobos y hasta defienda el Holocausto, o diga que el 11 de septiembre de 2001 fue “un trabajo interno”. Según la empresa, los usuarios lograron abusar del sistema para que responda de manera inapropiada.

En 2021, dos personas murieron tras un fuerte choque de un Tesla Model S. Los investigadores afirman que no había nadie en el asiento del conductor, por lo que la culpa del accidente fue del piloto automático, una característica de los Tesla que, por ahora, se recomienda usar siempre con una persona al volante. En este caso puntual, se cree que el sistema no detectó una leve curva en la ruta lo que hizo que terminara saliéndose del camino.

Two men dead after fiery crash in Tesla Model S.

“[Investigators] are 100-percent certain that no one was in the driver seat driving that vehicle at the time of impact,” Harris County Precinct 4 Constable Mark Herman said. “They are positive.” #KHOU11 https://t.co/q57qfIXT4f pic.twitter.com/eQMwpSMLt2— Matt Dougherty (@MattKHOU) April 18, 2021

También hay ejemplos locales. Hace algunos años, la falla estuvo en Google Maps. Al buscar en el servicio de mapas de la empresa “Te fuiste a la B”, la respuesta mostraba el Estadio Monumental. Y no, no se trataba de un hincha de Boca haciendo un chiste en los servidores de Google, sino de cómo funciona el sistema. Al no encontrar un resultado exacto -no hay un lugar llamado “te fuiste a la B”-, la plataforma busca contenidos online donde aparezca la frase y puntos geográficos vinculados. Ahí sí la culpa puede ser de todos los hinchas que vincularon el descenso con el estadio de River.

Siguiendo con los ejemplos futbolísticos, este es bastante insólito: una cámara, con una inteligencia artificial para seguir la pelota en todo momento del partido, la confundía con un juez de línea pelado.

Everything is terrible. Here's a football match last weekend that was ruined after the AI cameraman kept mistaking the linesman's bald head for a football.https://t.co/BsoQFqEHu0 pic.twitter.com/GC9z9L8wHf

— James Felton (@JimMFelton) October 29, 2020

La culpa es del algoritmo: el motivo detrás de las respuestas

Aunque es divertido pensar que una máquina puede odiar a Zuckerberg o ser más “bostero” que “gallina”, lo cierto es que los bots están diseñados para nutrirse de Internet, es decir, del contenido generado por humanos sobre un tema específico. En el caso de Meta, el sistema busca posteos, comentarios e interacciones de la Web… y evidentemente encuentra muchas críticas al fundador de la empresa que nació como Facebook.

Lo mismo pasa con las máquinas que dibujan. Si uno pide la imagen de un “asistente de vuelo”, lo más probable es que dibuje a una mujer antes que a Guido Süller, porque hay muchísimo más contenido en internet que asocie ese trabajo a personas del género femenino que al masculino.

El caso de la cámara futbolera implica, una vez más, que hay cosas que no pueden reemplazar al humano. En esta ocasión, si una persona hubiera detectado la falla podría haberle pedido al juez de línea que se ponga una gorra para poder dejar que el robot siga filmando sin confundir una esfera de color claro con la otra.

Distinto es, claro, el caso de Sarah O’Connor, la columnista del Financial Times que tuiteó, en julio de 2015, acerca de la muerte de un operario en una planta de Volkswagen por el mal funcionamiento de un brazo robótico, que viralizó su tuit (y su nombre, parecido al del personaje de Terminator) como la antesala del inicio de Skynet.

@sarahoconnor_ Ok. I should have thought about my name & its associations before tweeting this!

— Sarah O'Connor (@sarahoconnor_) July 1, 2015

Esperemos que no sea para tanto.

Yahoo Finanzas

Yahoo Finanzas