Cómo Nvidia se ha convertido en el 'rey' de los chips de inteligencia artificial

SAN FRANCISCO — Naveen Rao, un neurocientífico convertido en emprendedor del sector tecnológico, alguna vez intentó competir con Nvidia, el líder mundial en fabricación de chips diseñados para la inteligencia artificial.

En una empresa emergente que más tarde compró el gigante de los semiconductores Intel, Rao trabajó en chips diseñados para sustituir las unidades de procesamiento gráfico (GPU, por su sigla en inglés) de Nvidia, las cuales son componentes adaptados para tareas de inteligencia artificial como el aprendizaje automático. Sin embargo, mientras Intel avanzaba con lentitud, Nvidia actualizó en poco tiempo sus productos con nuevas funciones de inteligencia artificial que contrarrestaban lo que él estaba desarrollando, afirmó Rao.

Tras dejar Intel y dirigir una empresa emergente de software, MosaicML, Rao utilizó los chips de Nvidia y los evaluó frente a los de sus rivales. Descubrió que Nvidia se había diferenciado más allá de los chips al crear una gran comunidad de programadores de inteligencia artificial que todo el tiempo utilizan la tecnología de la empresa para sus inventos.

“Todo el mundo se basa primero en Nvidia”, aseguró Rao. “Si sacas un nuevo hardware, debes apresurarte para ponerte al día”.

A lo largo de más de diez años, Nvidia ha construido una ventaja casi inexpugnable en la producción de chips capaces de realizar tareas complejas de inteligencia artificial como el reconocimiento facial, de imágenes y de voz, así como la generación de texto para chatbots como ChatGPT. La otrora empresa advenediza del sector logró ese dominio al reconocer pronto la tendencia de la inteligencia artificial, adaptar sus chips a esas tareas y desarrollar piezas clave de software que ayudan al desarrollo de la inteligencia artificial.

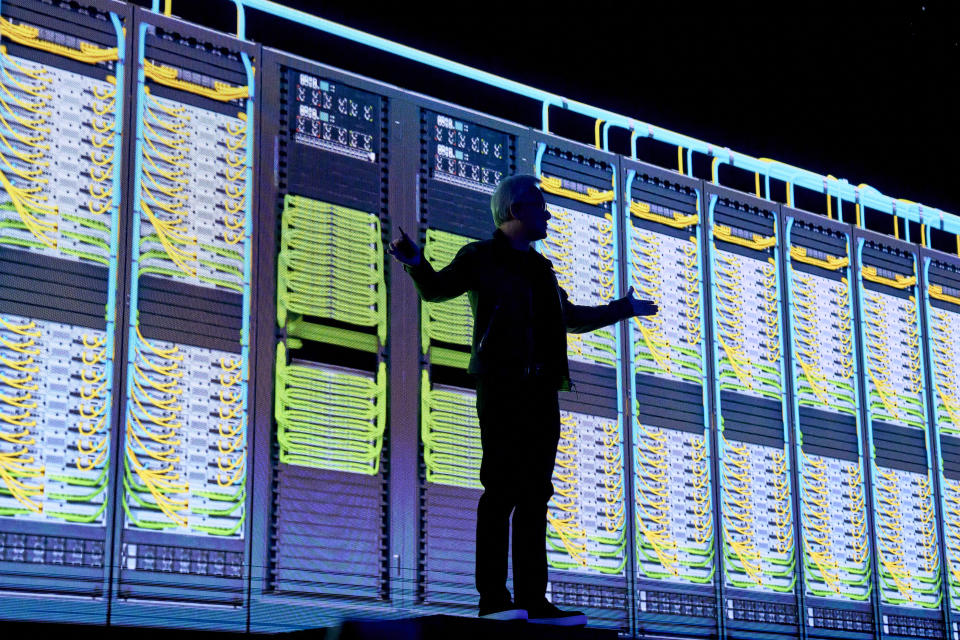

Desde entonces, Jensen Huang, cofundador y director ejecutivo de Nvidia, no ha dejado de elevar los estándares. Para mantener su posición de liderazgo, su empresa también les ha ofrecido acceso a los clientes a computadoras especializadas, servicios de cómputo y otras herramientas de su oficio emergente. A nivel práctico, esto ha convertido a Nvidia en un negocio integral para el desarrollo de la inteligencia artificial.

Un dominio del 70% del mercado

Aunque Google, Amazon, Meta, IBM y otras empresas también han producido chips de inteligencia artificial, Nvidia representa hoy más del 70 por ciento de las ventas de chips de inteligencia artificial y ocupa una posición todavía más importante en el entrenamiento de modelos de inteligencia artificial generativa, según la firma de investigación Omdia.

En mayo, el estatus de la empresa como la ganadora más visible de la revolución de la inteligencia artificial quedó claro cuando proyectó un salto del 64 por ciento en sus ingresos trimestrales, mucho más de lo que Wall Street pronosticaba.

Este miércoles, Nvidia ha brindado más señales sobre el auge en la demanda de la inteligencia artificial. En su trimestre más reciente ha multiplicado su beneficio trimestral por nueve. En concreto, en el segundo trimestre de su ejercicio fiscal, Nvidia ganó 6.188 millones de dólares, un 843% más que en ese tramo del año pasado, y duplicó su facturación hasta los 13.507 millones, un récord que atribuyó a los crecientes ingresos de su Centro de Datos (10.320 millones).

“Los clientes esperan dieciocho meses para comprar un sistema de Nvidia en vez de comprar un chip estándar disponible, ya sea de una empresa emergente o de otro competidor”, opinó Daniel Newman, analista de Futurum Group. “Es increíble”.

Huang, de 60 años, quien es conocido por su característica chaqueta de cuero negra, habló de la inteligencia artificial durante años antes de convertirse en uno de los rostros más conocidos del movimiento. Ha comentado en público que la computación está experimentando su mayor cambio desde que IBM definió cómo opera la mayoría de los sistemas y programas hace 60 años. Según Huang, las GPU y otros chips de uso especial están remplazando a los microprocesadores estándar y los chatbots de inteligencia artificial, a la compleja codificación de software.

“Hemos entendido que esto es una reinvención de cómo se hace la computación”, comentó Huang en una entrevista. “Y lo construimos todo desde cero, desde el procesador hasta el final”.

De los videojuegos a la inteligencia artificial

Huang ayudó a fundar Nvidia en 1993 para fabricar chips que reprodujeran imágenes en los videojuegos. Mientras que los microprocesadores estándar sobresalen realizando cálculos complejos de forma secuencial, las GPU de la empresa hacen muchas tareas sencillas a la vez.

En 2006, Huang fue más allá. Anunció una tecnología de software llamada CUDA, que ayudaba a programar las GPU para nuevas tareas, con lo cual pasaron de ser chips de un solo propósito a chips para propósitos más generales que podían realizar otras tareas en campos como la física y las simulaciones químicas.

Un gran avance se produjo en 2012, cuando los investigadores utilizaron las GPU para lograr una precisión similar a la humana en tareas como el reconocimiento de un gato en una imagen, un precursor de desarrollos recientes como la generación de imágenes a partir de indicaciones de texto.

Nvidia respondió cambiando “todos los aspectos de nuestra empresa para promover este nuevo campo”, declaró hace poco Jensen en un discurso de apertura en la Universidad Nacional de Taiwán.

La iniciativa, cuyo costo la empresa calculó en más de 30.000 millones de dólares a lo largo de una década, convirtió a Nvidia en algo más que un proveedor de componentes. Además de colaborar con importantes científicos y empresas emergentes, la firma formó un equipo que participa directamente en actividades de inteligencia artificial como la creación y el entrenamiento de modelos lingüísticos.

Una advertencia previa sobre lo que necesitan los practicantes de la inteligencia artificial llevó a Nvidia a desarrollar muchas capas de software clave más allá de CUDA, las cuales incluyen cientos de fragmentos de código prediseñados, llamados bibliotecas, que les ahorran trabajo a los programadores.

En septiembre pasado, Nvidia anunció la producción de unos nuevos chips llamados H100, mejorados para el manejo de las llamadas operaciones de transformación. Resultó que esos cálculos fueron la base de servicios como ChatGPT, los cuales han motivado el “momento iPhone” de la inteligencia artificial generativa, como lo llama Huang.

Para ampliar aún más su influencia, hace poco Nvidia también comenzó a forjar alianzas con grandes empresas tecnológicas y ha invertido en empresas emergentes de inteligencia artificial de alto perfil que utilizan sus chips. Una de ellas fue Inflection AI, firma que en junio anunció un financiamiento de 1300 millones de dólares de Nvidia y otros. El dinero se utilizó para financiar la compra de 22.000 chips H100.

Mustafa Suleyman, director ejecutivo de Inflection, afirmó que no había ninguna obligación de utilizar los productos de Nvidia, pero que los competidores no ofrecían alternativas viables. “Ninguno se le acerca”, opinó.

A últimas fechas, Nvidia también ha destinado dinero en efectivo y los escasos H100 a servicios advenedizos en la nube como CoreWeave, que permiten a las empresas rentar tiempo en computadoras en vez de comprar las suyas. CoreWeave, que operará con el hardware de Inflection y posee más de 45.000 chips de Nvidia, recaudó 2300 millones de dólares en deuda este mes para comprar más.

Nvidia no divulga precios ni políticas de asignación de chips, pero ejecutivos y analistas de la industria aseguran que cada H100 cuesta entre 15.000 y más de 40.000 dólares, según el empaque y otros factores, entre dos o tres veces más que el chip predecesor A100.

El precio “es un aspecto en el que Nvidia ha dejado mucho espacio para que haya más competencia”, afirmó David Brown, vicepresidente de la unidad de computación en la nube de Amazon, quien arguyó que sus propios chips de inteligencia artificial son una ganga en comparación con los chips de Nvidia que también utiliza.

Huang señaló que el mejor rendimiento de sus chips les ahorraba dinero a los clientes. “Si puedes reducir el tiempo de entrenamiento a la mitad en un centro de datos de 5000 millones de dólares, el ahorro es mayor al costo de todos los chips”, señaló. “Somos la solución de menor costo en el mundo”.

También te puede interesar | EN VIDEO: Lo bueno, lo malo y lo feo de la inteligencia artificial

c.2023 The New York Times Company

Yahoo Finanzas

Yahoo Finanzas